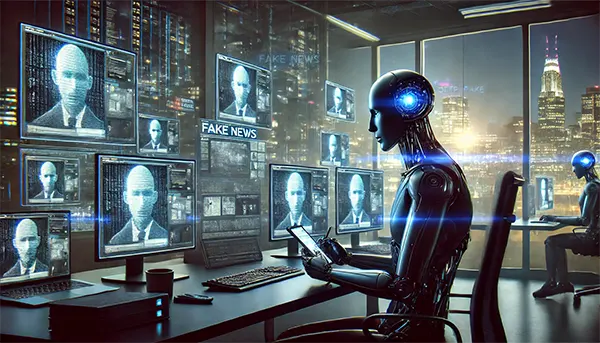

Sztuczna inteligencja w czarnym marketingu: Jak boty tworzą i rozpowszechniają dezinformację w 2025 roku

Sztuczna inteligencja (SI) zrewolucjonizowała wiele branż, ale w 2025 roku stała się również potężnym narzędziem w czarnym marketingu. Zautomatyzowane systemy, szczególnie boty oparte na SI, są wykorzystywane do tworzenia i rozpowszechniania dezinformacji, wpływania na opinię publiczną, rynki i krajobraz polityczny. W tym artykule omówimy stosowane metody, skalę problemu oraz możliwe środki zaradcze.

Wzrost dezinformacji generowanej przez SI

Kampanie dezinformacyjne napędzane przez sztuczną inteligencję nie są już dziełem pojedynczych hakerów czy małych grup – obecnie są organizowane przez zaawansowane sieci. Te sieci wykorzystują modele uczenia maszynowego do generowania wprowadzających w błąd treści, rozpowszechniania fałszywych narracji i manipulowania opinią publiczną na ogromną skalę.

Jednym z najbardziej niepokojących zjawisk jest wykorzystywanie generatywnej SI do tworzenia hiperrealistycznych deepfake’ów. Te filmy i obrazy wygenerowane przez SI mogą przekonująco imitować rzeczywiste osoby, przypisując im fałszywe wypowiedzi lub działania, które nigdy nie miały miejsca. Konsekwencje dla polityki, finansów i reputacji osobistych są ogromne.

Media społecznościowe stały się głównym celem kampanii dezinformacyjnych prowadzonych przez SI. Zaawansowane boty, wyposażone w przetwarzanie języka naturalnego (NLP), wchodzą w interakcję z użytkownikami, generując i wzmacniając treści, które wydają się autentyczne. Utrudnia to odróżnienie prawdziwych informacji od fałszywych.

Jak działają boty SI

Boty oparte na SI wykorzystują zaawansowaną automatyzację, łącząc uczenie głębokie z technikami inżynierii społecznej. Nie ograniczają się do publikowania ogólnych treści – analizują trendy, wykrywają popularne tematy i dostosowują swoje dezinformacyjne przekazy, aby płynnie wpasować się w toczące się dyskusje.

Niektóre boty wykorzystują uczenie ze wzmocnieniem do optymalizacji strategii zaangażowania. Testują różne komunikaty i mierzą reakcje, aby udoskonalać swoje podejście, czyniąc kampanie dezinformacyjne coraz skuteczniejszymi.

Boty oparte na SI infiltrują również zamknięte społeczności internetowe. Zdobywając zaufanie członków grup, manipulują dyskusjami, wzmacniając fałszywe narracje i sprawiając, że dezinformacja wydaje się bardziej wiarygodna dla docelowej publiczności.

Rola SI w manipulacji rynkowej

Rynki finansowe są szczególnie podatne na dezinformację generowaną przez SI. Fałszywe raporty mogą wpływać na ceny akcji, a kryptowaluty są częstym celem manipulacji. Fałszywe wiadomości generowane przez SI mają potencjał wywoływania ogromnych wahań na rynkach.

Zautomatyzowane algorytmy handlowe, które reagują na sentyment wiadomości, mogą zostać wprowadzone w błąd przez fałszywe informacje stworzone przez SI. Może to prowadzić do sztucznej inflacji cen lub nagłych spadków wartości aktywów, wpływając negatywnie na inwestorów i przedsiębiorstwa.

Boty SI są również wykorzystywane do ataków na reputację firm. Negatywne recenzje, sfabrykowane skandale i fałszywe skargi użytkowników mogą zaszkodzić wiarygodności marek, zmuszając przedsiębiorstwa do kosztownych działań obronnych.

Jak walczyć z dezinformacją generowaną przez SI

Rządy i firmy technologiczne opracowują zaawansowane mechanizmy wykrywania, aby walczyć z dezinformacją generowaną przez SI. Modele uczenia maszynowego są szkolone do identyfikacji treści syntetycznych, co pomaga w oznaczaniu wprowadzających w błąd materiałów.

Technologia blockchain staje się obiecującym rozwiązaniem w zakresie autentyfikacji treści. Weryfikując pochodzenie i autentyczność materiałów cyfrowych, blockchain może być potężnym narzędziem w walce z manipulacjami napędzanymi przez SI.

Podstawowe znaczenie ma również edukacja użytkowników w zakresie rozpoznawania dezinformacji. Świadomość istnienia botów SI oraz ich taktyk może zmniejszyć podatność społeczeństwa na zmanipulowane treści.

Przyszłe wyzwania i kwestie etyczne

W miarę rozwoju technologii SI zmieniają się również metody czarnego marketingu. Wyścig między dezinformacją napędzaną przez SI a narzędziami wykrywania staje się coraz bardziej intensywny, dlatego kluczowe jest dostosowywanie ram regulacyjnych.

Pojawiają się także kwestie etyczne związane z moderacją treści generowanych przez SI. Chociaż zautomatyzowane systemy pomagają wykrywać dezinformację, mogą również przypadkowo tłumić legalne wypowiedzi. Znalezienie równowagi stanowi istotne wyzwanie.

Aby skutecznie przeciwdziałać dezinformacji, niezbędna jest współpraca międzynarodowa. Rządy i organizacje zajmujące się cyberbezpieczeństwem muszą współdziałać w celu opracowania polityk, które ograniczą ryzyko, jednocześnie chroniąc wolność cyfrową.

Przyszłość SI i integralność informacji

Przyszłość sztucznej inteligencji w czarnym marketingu będzie zależeć od tego, jak skutecznie społeczeństwo poradzi sobie z regulacją i przeciwdziałaniem jej nadużyciom. Chociaż SI niesie zagrożenia, oferuje również narzędzia do identyfikacji i neutralizacji dezinformacji.

Tworzenie przejrzystych modeli SI z wyjaśnialnym procesem decyzyjnym może pomóc w odróżnieniu autentycznych treści od zmanipulowanych narracji. Kluczową rolę odegrają inwestycje w etykę SI.

Zachowanie integralności informacji w erze cyfrowej wymaga połączenia zaawansowanej technologii, regulacji prawnych i czujności społecznej. Tylko w ten sposób można skutecznie przeciwdziałać wpływowi dezinformacji napędzanej przez SI.

Podobne wieści

-

Klonowane landing pages i podszywanie się pod d...

Klonowane landing pages i podszywanie się pod d...Klonowane strony docelowe oraz domeny łudząco podobne do oryginalnych to …

-

„Negatywny PR jako usługa”: jak wyglądają komer...

„Negatywny PR jako usługa”: jak wyglądają komer...Określenie „negatywny PR jako usługa” bywa używane wobec zorganizowanych ataków …

-

Jak działają sieci fałszywych opinii w 2026 rok...

Jak działają sieci fałszywych opinii w 2026 rok...Sieci fałszywych opinii dawno przestały oznaczać „kilka kupionych ocen”. W …